La enorme dificultad de aceptar que el chatbot de inteligencia artificial inventa y se equivoca

También: Google empieza a dar síntomas de querer el divorcio de la web abierta; Un influencer ha muerto. Y otro, y otro

Amigas, amigos, seguimos con un Error500 de verano: irregular en frecuencia, ¡se acumulan los temas!. No hay garantías de cuando habrá nueva edición, si que es improbable que publique en las dos próximas semanas.

Un apunte: en Linkedin he publicado una lista de 10 buenas lecturas tecnológicas para el verano Nada mejor que tener horas lentas de lectura, regodearse en alguna idea sin prisa, sin agobio de ser productivos, dejando que conocimiento y disfrute confabulen.

Google empieza a dar síntomas de querer el divorcio de la web abierta

La web lleva funcionando igual desde que se inventó. Un cliente hace una petición desde un navegador, el servidor le responde con el contenido de la página y, una vez este contenido es recibido por el cliente, el creador de la página pierde el control: el cliente se lo puede descargar, lo puede modificar, filtrar que parte visualiza y qué no… pero ahora Google quiere añadir una capa de control.

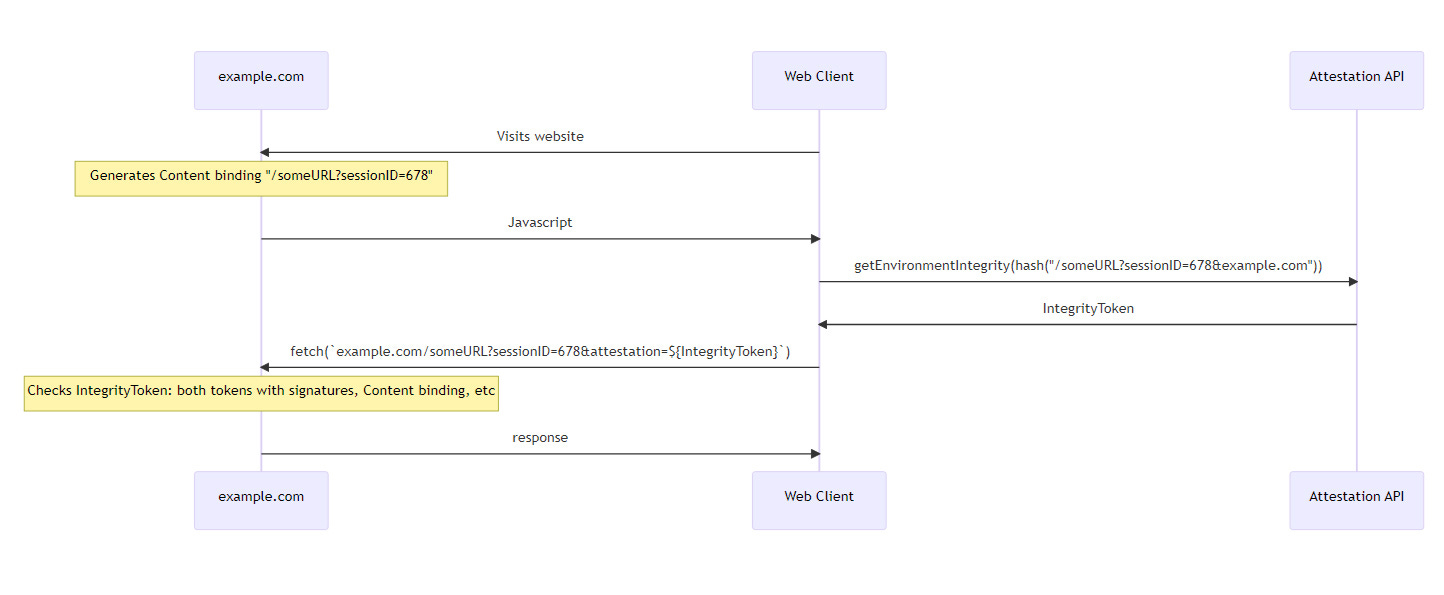

En Ars Technica explican bien la nueva propuesta de cuatro ingenieros de Google para un estándar web: crear una API de integridad del entorno que permita a los sitios web saber si el navegador del usuario ha sido modificado o no. La “Web Integrity API” permitiría que el servidor web solicitara al usuario que pasara una “prueba de atestación del entorno” antes de enviarle los datos. El usuario tendría que contactar con un servidor de atestación de terceros y obtener un token de integridad firmado que verificara su entorno (que su navegador no ha sido modificado, que no tiene las extensiones inadecuadas) y desbloqueara el contenido.

¿Cómo lo venden? Apuntan a que esta API podría ayudar a los anunciantes a contar las impresiones de los anuncios, a detener los bots de las redes sociales, a hacer cumplir los derechos de propiedad intelectual, a evitar el fraude en los juegos web y a mejorar la seguridad de las transacciones financieras. Dicho de otro modo, como explican en Techdirt, se trata de incorporar DRM en el navegador web: restringir el acceso a los usuarios que tengan el navegador rooteado o personalizado (por ejemplo con un bloqueador de anuncios, con un VPN para acceder desde otro país o con herramientas anti rastreo), evitar que nadie se salte muros de pago o acceda a contenidos tras ellos.

La misión original de Google era "organizar la información del mundo y hacerla universalmente accesible y útil". Con este DRM para la web lo que plantea son mecanismos de control: con la Web Integrity API, un “servidor de atestación” (seguramente Google) podrá denegar el acceso a aquellos usuarios que no utilicen el software y el hardware adecuados (Google lidera el mercado de navegadores en móvil y escritorio) para evitar que se salte los anuncios (Google es el mayor intermediario publicitario en internet) o algo por lo que no haya pagado. El “universalmente accesible” pasaría a ser “restringido según hayas pagado o no impidas a nuestra publicidad aparecer como queremos”.

Anotaría que, por otro lado, con la idea de transformar el buscador con la IA generativa, Google tiene el dilema de por dónde romper el ecosistema que ha creado con la web abierta:

Google tiene que decidir a quien va a perjudicar con su cambio en el buscador. Y rápido

Esta semana no hay tanto “resumen tecnológico de tendencias” y sí más un “a fondo” con un tema sobre el que llevo reflexionando años, Google y su sueño de un buscador que responde y deja de darte enlaces. Promo: El año de aprender inteligencia artificial

Un influencer ha muerto. Y otro, y otro

Sharath Kumar, influencer de 23 años, ha muerto mientras grababa un vídeo en unas cataratas en India. El creador de contenido se encontraba grabando para TikTok (otras fuentes apuntan a Instagram, no he conseguido llegar a sus perfiles) en las cataratas de Arasinagundi. Mientras estaba subido a una roca, resbaló y cayó al agua, dejando un amigo grabado el momento de su fallecimiento. Lo han contado en muchos sitios, pero prefiero enlazar a IndianExpress que tiene el buen gusto de no incrustar el vídeo del suceso.

Tenemos también a Remi Lucidi, influencer y escalador que murió tras caer desde un rascacielos en Hong Kong. El creador de contenido falleció el pasado jueves a los 30 años al precipitarse desde la planta 68 de un edificio de Hong Kong. Lo cuentan en Vandal y El Español.

Por último la creadora Zhanna Samsonova era una influencer vegana fallecida por causas relacionadas con la inanición tras comer solo frutas y verduras crudas - y no beber agua - durante años. Este estilo de vida era el centro de su contenido en plataformas.

Morir por conseguir más likes y alcance en redes sociales suena a una terrible decisión. Lo podemos expresa de otra manera: por likes y alcance que derivan en fama, dinero y estatus social. Cómo se consigue todo esto en las plataformas de contenidos actuales puede haber ayudado a seleccionar a estos creadores fallecidos: el combo de algoritmos más preferencia de los usuarios junto a una masificación de la creación empuja a cada vez propuestas más extremas (en el caso de Samsonova posiblemente patológica).

Relacionado: Internet ahora es una máquina de convertir todo - tu tragedia y mi conspiración incluidos- en contenido.

La enorme dificultad de aceptar que el chatbot de inteligencia artificial inventa y se equivoca

En esta pieza en Fortune abordan un asunto que hemos discutido varias veces por aquí y en monos estocásticos: figuras como Daniela Amodei y Emily Bender tienen serias dudas de esta generación de inteligencia artificial basada en grandes modelos de lenguaje (a su vez basados en deep learning / Transformer) se pueda librar de errores, invenciones y alucinaciones.

Conviene recordar, una vez más, que por diseño estos sistemas son una suerte de “autocompletado” del texto que reciben. En tanto en cuanto no hay una comprensión real de lo que están recombinando, lo razonable es ser escéptico respecto a conseguir completa fiabilidad factual, algo para lo que no están diseñados. Sam Altman de OpenAI, citado la pieza de Fortune, es en cambio optimista: apunta a un año y medio o dos para “arreglar esto”. En mi experiencia, GPT-4 alucina mucho menos que sus rivales y es bastante mejor que GPT-3.5 o GPT-3.

La alucinación, si me permiten la expresión, “is a feature not a bug” de los modelos que aprender a completar textos a partir de millones de ellos. Es probable que la confianza de Altman resida en la fase RLHF (Reinforcement learning from human feedback) tras el entrenamiento . Al igual que a GPT-3.5 consiguieron convertirlo en un chat y, con el tiempo, inmune a los intentos de sacarlo de los límites que le impuso Open AI gracias a la instrucción que le proporcionaron miles de humanos, es posible que confíen en que ahí se le puedan ayudar mecanismos que eliminen o minimicen la alucinación. De hecho, insisto, GPT-4 es ya bastante bueno en esto.

Hay una variable extra en este asunto, cuando la inteligencia artificial alucina o inventa sobre ti. En esta pieza de NYT tenemos algunos casos delicados, como el de un bot apuntando que la política Maria Renske Schaake es una terrorista. El Wapo recogía una investigación a OpenAI por parte de la Comisión Federal de Comercio de EEUU. El organismo de control está investigando si OpenAI ha infringido las leyes de protección de la intimidad y del consumidor al no garantizar la seguridad de los datos y permitir que ChatGPT genere información falsa sobre las personas.

En caso de que la investigación prosperase y se hiciese responsable a OpenAI de la factualidad de las respuestas de ChatGPT, la viabilidad del producto se vería menoscabada: con el tiempo suficiente todos podríamos conseguir alguna respuesta inadecuada sobre nosotros o terceros susceptible de sanción (o de indemnización).

En el sector se baraja que las IAs se puedan acoger a la sección 230 que protege a los responsables de plataformas por el contenido subido por los usuarios. También se ha mencionado alguna vez la “libertad de expresión”. El encaje de ambos casos es dudoso, ni hay subida de contenidos por terceros que se puedan hacer responsables ni ChatGPT es una persona ejerciendo su libertad de expresión.

De fondo hay un nudo difícil de resolver. Los humanos somos propensos al antropomorfismo, atribuimos características humanas, agencia y sensibilidad, a cosas que no lo son. Tratamos a los robots que barren como mascotas y vemos caras en las nubes. Al hablar con un chatbot que nos responde con seguridad somos crédulos, si se expresa con tacto o sensibilidad, otorgamos sentimientos. Por muy difícil que resulte resulta más razonable que cambien los sistemas de inteligencia artificial que la naturaleza humana.

Breves

Glosario amigable de conceptos clave sobre Inteligencia Artificial. Carlos Guadián

Por qué Apple apuesta por la tecnología de Pixar para hacer funcionar el metaverso. The Verge. Javier Lacort profundiza en el tema en este episodio de Loop Infinito.

Rusia lleva su guerra informativa de Ucrania a los videojuegos. La propaganda está apareciendo en Minecraft y otros juegos y grupos de debate populares, mientras el Kremlin intenta ganarse a nuevas audiencias. NYT.

José Mendiola en Yahoo, “Antes del iPhone enloquecimos todos con Palm (y yo incluso llegué a ganar dinero con ella)”

La “pesadilla” de un joven ingeniero español en Apple: “Llegué a hacer jornadas de 20 horas”. El Diario

Mi última adicción es la página de la Wikipedia del LK-99, que ha empezado a seguir los intentos de replicación en tiempo real. Ya hablamos del candidato a superconductor a temperatura ambiente la semana pasada.

Os dejo con la mejor pieza de contenido que me he cruzado estas semanas, JC Pieri con un chimpancé haciendo scroll en las fotos de la cámara en las que aparece