El humano en el proceso, el director de orquesta y la bolsa de Doritos

En la inteligencia artificial agéntica se quieren pasar años en meses

Es probable que Taki Allen no tenga una opinión demasiado favorable de la inteligencia artificial. El pasado 20 de octubre, en su instituto de Baltimore, varios agentes se acercaron a él con las armas desenfundadas, le obligarona a tirarse al suelo, le esposaron y lo registraron.

Lo que desencadenó su detención fue que, en una sala lejana, un sistema de vigilancia con “detección de armas por IA” - Omnilert Gun Detect, integrado en las 7.000 cámaras del distrito escolar - clasificó lo que aparecía en pantalla (la silueta de Taki) como sospechosa, con algo que el algoritmo clasificó como una posible pistola. Era una bolsa de Doritos.

En esta historia se ha puesto el énfasis en los márgenes de error de los sistemas de clasificación de imágenes de la inteligencia artificial. Con el número de cámaras y las horas que pasan grabando, si tiramos por lo bajo y hablamos de 500.000 análisis diarios, tendríamos unos 50 falsos positivos para un sistema con una tasa de acierto del 99,99%. Que Taki sea negro nos devuelve a los debates sobre sesgos existentes en los datos de entrenamiento de la inteligencia artificial.

Pero hay algo más en este caso de especial interés. La alerta del sistema de IA no iba directamente a la policía sino que exigía una revisión humana previa. Según la reconstrucción de los medios locales, el positivo se revisó y llegó a marcarse como resuelto en el sistema, pero una cadena de malentendidos llevó igualmente a que se avisara a la policía.

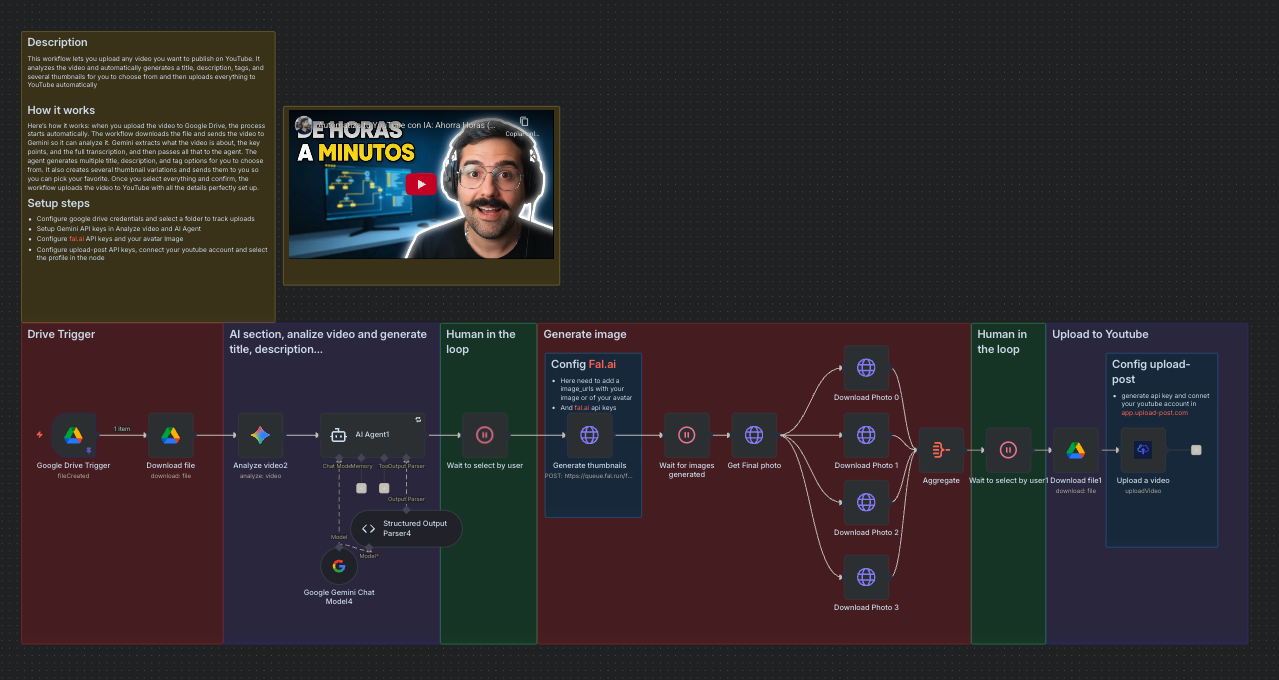

En estos tiempos de IA agéntica hemos visto moverse el discurso sobre qué supone adoptarla en serio. Hemos pasado del copiloto, del becario / ayudante al que pedimos pequeñas tareas atómicas de procesamiento o generación, a lo que se ha venido a llamar “el humano en el proceso”: la IA se encarga de un workflow más complejo que la generación o consulta puntual, interactúa con varios sistemas y además de planificar acciones, le permitimos ejecutarlas.

El discurso, a partir de los sistemas de IA agéntica y de plataformas para crear estos conjuntos de procesos, ha desembocado en la idea de “orquestación de agentes de inteligencia artificial”: el humano pasa de estar pendiente de los errores, límites y alucinaciones del agente a ser una suerte de entrenador y coordenador de flujos complejos.

Es el momento de plataformas como n8n o Activepieces. Sobre ellos y la orquestación me interesó leer a Dries Buytaert, fundador de Drupal, en su blog. Tecnólogos como Buytaert intentan anticipar las consecuencias de este giro. Algunas las comentamos con el caso del agente de Perplexity comprando en Amazon, otros son más difíciles de perfilar: los sistemas software pasarían de ser el punto central de la resolución de una tarea con la interacción de humanos a convertirse en nodos - más o menos importantes - dentro de redes orquestadas por agentes de inteligencia artificial. Hay que repensar estas piezas para disparar flujos en otros sistemas y recibir acciones de vuelta.

Sigo con la sensación de que la industria quiere acelerar demasiado.

Que los años necesarios para la madurez de esta tecnología se espera que suceda en meses; que el problema de la alucinación, que sigue siendo el pecado original de los LLMs que hay debajo de todo esto, está siendo obviado de la discusión; que un error en una acción de la IA, que sucederá mucho aunque acierte del 99,99% de las veces, se arrastra, acumula y amplifica en todo el workflow.

Es por eso que no estamos para nada listos para automatizar procesos complejos con IA. Que debemos mantener el humano en el proceso porque, por muy buena que sea esta tecnología estocástica y aleatoria, el riesgo de error persiste y se impone. Podríamos llamarlo el síndrome de la bolsa de Doritos en la IA.

Puede ser nefasta la cadena de consecuencias que nace de una mala información, que deriva en una conclusión errónea, que acaba en una acción desastrosa. Sin mecanismos intermedios que pongan en cuarentena lo que la IA dicta se puede liar y mucho. Se espera que la IA defina y resuelva por si solo cualquier proceso ineficiente o mal planteado y creo que es un gran error. La IA será una pieza más en cualquier engranaje mal engrasado.

Pero claro, el espejismo de que todo se automatiza y organiza automágicamente es muy tentador :/

Tienes toda la razón en la necesidad de proporcionar supervisión humana en los procesos de automatización. La IA sigue con errore (igual que los humanos) y por ello una supervisión doble es lo mejor.

Pero sobre el tema de procesos automatizados yo echo de menos que algunas empresas no se planteen usar la IA para automatizar cosas simples y sencillas que además los usuarios ayudarían a que el sistema aprendiese, antes de lanzarse a gandes automatizaciones. Solo como ejemplos:

- Un sistema de streaming que recuerde lo que ya he visto y no me vuelva a recomendar contenido que he visto hace poco.

- Idem con la publicidad: que no me publicite lo que acabo de ver

- Agentes internos del sistema operativo: si yo siempre busco y copio cosas parecidas... que aprende y me ahorre pasos.

Se trataría de ir con cosas pequeñas... pero aquí parece que solo vende lo grande.