Exponencial

Volvemos a debatir la expansión exponencial de la inteligencia artificial. Si la IA puede generalizar en toda área de conocimiento humano ¿crecerá exponencialmente lo que podremos hacer ahora?

“Lo más sorprendente ahora mismo es la falta de reconocimiento público de lo cerca que estamos del final de la expansión exponencial. Para mí, es absolutamente increíble que, dentro y fuera de la burbuja, la gente siga hablando de los mismos temas políticos de siempre, y que, a la vez, estemos cerca del final de la expansión exponencial”

Es una frase del comienzo de la entrevista de Patel a Dario Amodei. Ese “fin de lo exponencial” ha demandado una cierta exégesis. ¿Se refiere el CEO de Anthropic a que la inteligencia artificial se pegará con un muro? ¿Que lo que viene ahora es una meseta sin mejoras llamativas? Si vemos el resto de la - absolutamente imperdible - entrevista podemos desechar esa interpretación.

Para Amodei tendremos "un país de genios en un data center" entre 2026 y 2027. No se refiere a que el progreso se detenga, sino a lo contrario: a que estamos en el tramo final de la curva, el que va del "estudiante de bachillerato brillante" al "premio Nobel", y que la velocidad de escape ya se ha alcanzado.

El punto clave técnico, en mi opinión, es su hipótesis respecto al modo actual de crear los modelos de inteligencia artificial. Hace unos meses discutíamos cómo el aprendizaje por refuerzo estaba llevando a los modelos grandes de lenguaje a ser excelentes en programación y matemáticas. La misma gente de Anthropic señalaba que esta forma de entrenar una IA venía con un precio: había que ir especialidad por especialidad.

Amodei plantea ahora que el aprendizaje por refuerzo está generalizando sobre los LLMs. Es decir, que lo que está haciendo ahora la IA es aprendiendo a razonar y a planificar, a adquirir los mecanismos que la llevarían a ser competente en cualquier tarea de la creatividad y el conocimiento. No sólo a reflejar interpolando los datos de entrenamiento, sino a generalizar a partir de ellos.

Amodei está en su momento. Lleva años viendo cumplidas sus apuestas, con la empresa multiplicando sus ingresos 10 veces cada año. Como con todos los científicos, creo que hay que separar sus argumentos técnicos de los pronósticos sociales, evitar hacer esa transferencia de autoridad. Aún así, en la entrevista reconoce que Claude Code ha aumentado la productividad en programación entre un 15 y un 20 %. Es un salto enorme, pero no es, todavía, exponencial.

La IA se automejora

Por su parte, OpenAI anunció hace un par de semanas su nuevo modelo especializado en programación. Cito de la presentación: “GPT-5.3-Codex es nuestro primer modelo que fue clave en su propia creación“. El equipo de Codex utilizó versiones tempranas del modelo para depurar su propio entrenamiento, gestionar su propio despliegue y diagnosticar resultados de pruebas.

Estamos entrando en la era de los modelos automejorados. Los principales laboratorios ya automatizan fracciones significativas de sus operaciones de investigación e ingeniería. Los modelos son lo suficientemente potentes como para plantear hipótesis sobre el diseño del entrenamiento y programar el código para probarlas.

Me ha interesado como Dean W. Ball plantea dos escenarios. Utiliza una metáfora extendida: imagina un Bugatti que pasa a 300 km/h y luego otro a 400 km/h; un transeúnte apenas notará la diferencia entre “extremadamente rápido” y “récord mundial de velocidad”. Ese es el escenario conservador, en el que la automatización de la investigación simplemente acelera el progreso con una ganancia significativa de productividad. El otro escenario sería que el Bugatti consiguiera volar: que surjan paradigmas enteramente nuevos, que la IA se abarate dramáticamente y que aparezcan capacidades cualitativamente distintas.

La pregunta clave, para mí, es qué ocurre cuando los investigadores humanos cuentan con ejércitos de investigadores automatizados. ¿Se multiplican esas ganancias o resulta que los humanos ya estaban encontrando casi todo lo que había por encontrar? (disculpen si el término adecuado es más bien “inventar”). Es más, sigo pensando que los humanos siguen siendo mejores en la idea genuinamente nueva y que GPT-5.3-Codex sólo prueba que en poco tiempo un modelo puede mejorar significativamente a su predecesor. Pero es una mejora lineal, no exponencial.

La autonomía

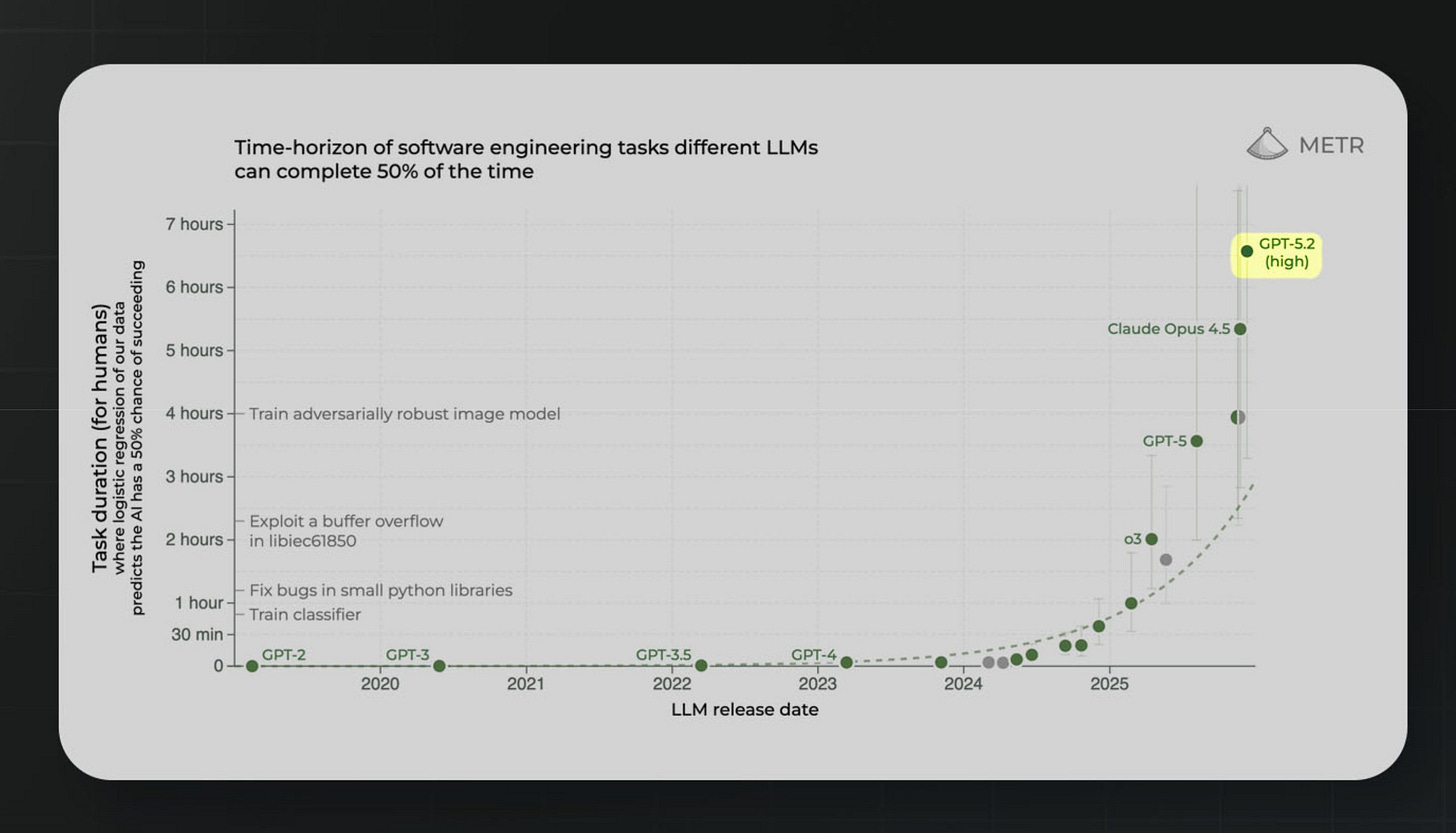

La organización METR, que desarrolla evaluaciones independientes de IA, aporta la medición que sustenta el optimismo. Su investigación muestra que la duración de las tareas que los agentes completan de forma autónoma se duplica cada siete meses. GPT-5.2 ya muestra un horizonte temporal de unas 6,6 horas en tareas de software. Si la tendencia se mantiene, pronto hablaremos de agentes que completan proyectos de semanas.

Sin embargo, aunque los optimistas de la industria se centran en este banco de pruebas, en muchos otros las mejoras que vemos son mucho más modestas y escalonadas. Hay algo de cherry-picking en señalar el que resulta exponencial frente a los que son lineales.

Programar

En Spotify, su co-CEO Gustav Söderström ha declarado durante la presentación de resultados que sus mejores desarrolladores “no han escrito una sola línea de código desde diciembre”. Utilizan un sistema interno llamado Honk, construido sobre Claude Code. Spotify ha lanzado más de 50 funcionalidades nuevas en 2025 y lo atribuye directamente a esta aceleración.

En Axios, su CTO cuenta que una tarea que el año pasado llevaba tres semanas, esta última la completó con “equipos de agentes” de IA en 37 minutos. Su equipo de producto y tecnología pasó de 63 a 43 personas, duplicó su producción en enero y va camino de volver a duplicarla en febrero. Proclama que los agentes ya escriben mejor código que él. Ahora dedica su tiempo a pensar qué construir, no cómo construirlo. Y el nuevo cuello de botella ya no es escribir código: es la velocidad a la que los humanos pueden absorber los cambios. Mientras tanto, la antigua organización de ingeniería de Twitter, que solía tener dos mil ingenieros, funciona ahora con 30.

Y en España, Jorge Valero de AEDAS Homes lo expresa de otra manera: “Esto no va de cuántas personas puedo despedir, sino cuántas tareas que no podía hacer antes voy a poder empezar a hacer ahora”. En la entrevista que le hacemos hace un diagnóstico al que atendería: manteniendo plantilla pueden acometer tareas que antes de la IA eran impensables por su complejidad, una vez que las normales - e incluso las difíciles- han pasado a ser mucho más asequibles.

Por aquí hemos discutido las ideas nuevas de management: que el emprendedor debe hacer lo que mejor sabe y delegar todo lo demás a la IA o la filosofía del equipo mínimo hiperproductivo, del botscaling. Confieso que leerlas el año pasado me causó mucha más perplejidad que la que me provoca ahora.

El caso es que 2026 puede ser el año en que seguir cualquier categoría en digital se convierta en una locura: la capacidad de diseñar y desarrollar nuevas funcionalidades es la fruta madura al alcance de la mano.

Pero, en la práctica, el mundo real impone sus limitaciones. El visto bueno de los que tienen que aprobar, la revisión legal, las pruebas de que no se rompe nada (en una organización seria no se va a dejar en manos de la IA), la inercia, la capacidad de absorción del mercado, los rendimientos decrecientes de cada nueva idea y el vamos a pensarlo bien. Lineal, no exponencial. Seguramente.

siempre ilustrativo ;)